Zelfrijdende auto's en zorg- en operatierobots zijn in aantocht. Artificiële ofwel kunstmatige intelligentiesystemen kunnen onze wegen veiliger, het leven van gehandicapten en ouderen gemakkelijker en het herstel van patiënten sneller maken. De beloften van kunstmatige intelligentie zijn enorm en de mogelijkheden eindeloos. Maar kunnen we machines ons leven toevertrouwen? Als zij namens ons handelen, doen ze dat dan op een verantwoordelijke manier? Als er iets misgaat met de kunstmatige intelligentie (AI), wie is daar dan op aan te spreken? En wat gebeurt er als we er niet in slagen om vooroordelen en discriminatie aan te pakken? Aan de Universiteit Utrecht werken we aan het ontwerpen van betere, meer verantwoordelijke AI-systemen waar wij mensen op kunnen vertrouwen. Dit houdt in dat we de machines leren om te beredeneren en keuzes te rechtvaardigen, net zoals wij dat doen. En het betekent ook dat we een aantal van de meest urgente ethische en juridische uitdagingen die AI met zich meebrengt oplossen.

Het ontrafelen van de black box van AI

Geschatte leestijd: 15 minuten

Hier is een gedachte-experiment: Je staat bij de tramhalte en je ziet een op hol geslagen karretje over de rails op vijf mensen - die dit niet opmerken - afkomen. Stel je zou het karretje kunnen omleiden naar een spoor waar zich maar één persoon bevindt. Wat doe je? Offer je die ene persoon op om die andere vijf te redden?

Het trolleyprobleem is al decennialang een klassiek dilemma in cursussen ethiek en filosofie. "Zodra de experimentele zelfrijdende auto's de weg op gingen, werden we geconfronteerd met een dilemma uit de echte wereld: met welke instructies moet het AI-systeem geprogrammeerd worden om te handelen in een leven-of-dood situatie?" stelt filosoof Sven Nyholm van de Universiteit Utrecht. "Dat willen we weten voordat we onze veiligheid aan het systeem toevertrouwen."

Wat als een autonome auto iemand verwondt of doodt? Wie moet hier dan verantwoordelijk voor gehouden worden?

Weten hoe AI-systemen tot beslissingen komen, is niet altijd duidelijk of rechttoe, rechtaan. Veel algoritmische systemen functioneren als een black box: er gaat informatie in en er komen beslissingen uit, maar we hebben betrekkelijk weinig idee hoe ze tot die beslissingen zijn gekomen.

"Wat als een autonome auto iemand verwondt of doodt? Wie moet hier dan verantwoordelijk voor gehouden worden? Is het de niet-oplettende persoon die achter het zelfrijdende stuur zit? Zijn het de autoriteiten die de auto op de weg toelieten? Of is het de fabrikant die de voorkeuren zo heeft ingesteld dat het systeem koste wat het kost de passagier beschermt?", stelt Nyholm, die een invloedrijk artikel heeft geschreven over de urgentie van ethische instellingen van de ongevallenalgoritmen voor autonome voertuigen. "Mensen willen iemand de schuld geven, maar we hebben nog geen universele overeenstemming bereikt."

Als samenleving is het van essentieel belang om te bespreken wat deze kunstmatige intelligente systemen wel of juist niet moeten doen, voordat ze onze wegen - en vrijwel elk ander aspect van ons leven - gaan overspoelen. Want hoe kunnen we ooit systemen vertrouwen waarvan we de beslissingen niet begrijpen? Hoe kunnen we rekenschap afleggen voor niet-gewenste gevolgen? En kunnen deze worden voorkomen? Sinds de jaren tachtig heeft de Universiteit Utrecht een diverse gemeenschap van deskundigen opgebouwd om kunstmatige intelligentie uit die black box te halen, zodat de beloften van deze technologische revolutie voluit waargemaakt kunnen worden.

"Wat kunstmatige intelligentie zo impactvol - en veelbelovend - maakt, is dat het computers en machines het vermogen geeft om menselijke intelligentie te modelleren, na te bootsen en zelfs te verbeteren. AI-systemen kunnen hun omgeving aanvoelen, ze kunnen leren en ze kunnen beredeneren, opdat ze zelf beslissingen kunnen nemen over acties om hun vooropgestelde doelen te bereiken", zegt Mehdi Dastani, programmaleider van de master Artificial Intelligence aan de Universiteit Utrecht. Hij voegt daaraan toe: "Juist het vermogen om te leren van ervaringen die zijn opgedaan met data, staat centraal in veel van de revolutionaire toepassingen van AI vandaag de dag." Het is de reden waarom Google-vertalingen nu eindelijk aanvaardbaar zijn en waarom Gmail met succes 99,9% van de spam filtert. Maar het is essentieel dat mensen de controle houden over de AI-technologie, zegt Dastani, en onderscheid maken tussen het goede, het slechte en het lelijke.

Het goede - AI gebruiken om ziekten te behandelen

Een virtuele slaapcoach voor mensen met slapeloosheid, een spel voor kinderen met een chronische ziekte, of een robot die sociale afstand nastreeft om de verspreiding van het coronavirus tegen te gaan. Naast de belofte van gebruiksgemak en werkefficiëntie kan AI een rol spelen bij het redden van levens. "AI-systemen kunnen helpen bij het opsporen van afwijkingen in medische beelden van patiënten, die zelfs de beste artsen kunnen ontgaan", zegt Kenneth Gilhuijs, universitair hoofddocent aan het Image Sciences Institute van het Universitair Medisch Centrum Utrecht. Gilhuijs heeft een computerondersteund diagnoseprogramma ontwikkeld dat artsen binnenkort zou kunnen helpen borstkanker eerder, sneller en nauwkeuriger op te sporen dan op dit moment mogelijk is.

Ons AI aangedreven systeem kan het aantal foutpositieven tot 64% terugbrengen, zonder gevallen van borstkanker te missen.

Het idee ontstond nadat een studie, geleid door zijn collega en kankerepidemioloog Carla van Gils, suggereerde dat het gebruik van Magnetic Resolution Imaging (MRI) bij de screening van vrouwen met extreem hoge borstdensiteit de mortaliteit als gevolg van borstkanker in deze groep zou kunnen helpen verminderen. Door MRI toe te voegen aan de standaard mammografie werden ongeveer zeventien extra gevallen van borstkanker ontdekt; de keerzijde was dat 87,3% van het totale aantal weefselafwijkingen dat werd doorverwezen voor aanvullende MRI of biopsie foutpositief voor kanker was. "Als het aantal biopsies van goedaardige laesies kan worden verminderd, zou dat de last voor vrouwen en klinische middelen verlichten", dacht Gilhuijs.

"We hebben nu aangetoond dat het door AI aangedreven systeem het aantal foutpositieven tot 64% kan terugbrengen, zonder gevallen van kanker te missen", zegt Gilhuijs, in wiens lab het algoritme werd getraind op een database van MRI's van 4.873 vrouwen in Nederland die hadden deelgenomen aan het onderzoek van Van Gils. "We willen dit algoritme nog verder verbeteren om radiologen in staat te stellen zich nog meer te kunnen concentreren op de gevallen die een ruimer menselijk oordeel vereisen."

Oncologen blijven verantwoordelijk voor de diagnose, merkt Gilhuijs op, en "zij zetten de computer in als hulpmiddel, zoals zij een stethoscoop gebruiken. Het is belangrijk dat de eindgebruikers van het beslissingsondersteunende systeem - de artsen - actief betrokken zijn bij het ontwerp ervan. Dit zorgt voor betere acceptatie en meer vertrouwen."

Het slechte - AI gebruiken om menselijke beslissingen te overstemmen

Maar wat gebeurt er als gebruikers er niet bij betrokken zijn en niet weten hoe een AI 'second opinion' tot stand is gekomen?

Wat er dan zou kunnen gebeuren is een schending van de rechten van mensen, zegt rechtsgeleerde aan de Universiteit Utrecht Max Vetzo. Dat is wat er gebeurde toen een rechter in Wisconsin vertrouwde op een algoritmisch instrument - genaamd COMPAS - om te beslissen over de veroordeling van een man die was aangetroffen als bestuurder van een bij een schietpartij betrokken auto. Het algoritme in kwestie classificeerde de verdachte als een 'hoog risico' op recidive, zodat de toen 35-jarige werd veroordeeld tot zes jaar gevangenisstraf. Vetzo: "De wet op de grondrechten garandeert dat verdachten de beslissing van een rechter kunnen weerleggen en aanvechten. In dit geval, toen de advocaten tegen de beslissing in beroep gingen, kon de rechter niet uitleggen hoe het systeem tot die uitkomst was gekomen."

Dat wil niet zeggen dat het vonnis verkeerd was of dat algoritmische hulpmiddelen niet op een positieve manier kunnen worden gebruikt, merkt Vetzo op. "AI kan een waardevolle sparringpartner zijn voor rechters en kan zelfs vooroordelen in het strafrechtsysteem verminderen", zegt hij. "Maar het is de verantwoordelijkheid van de rechters om de transparantie van de rechtsgang te waarborgen. Zij moeten op zijn minst kunnen begrijpen hoe deze algoritmische systemen tot beslissingen komen, en zij kunnen ook helpen met de beoordeling welke juridische problemen het gebruik van AI met zich meebrengt. Zo niet, hoe kan iemands grondrecht op een eerlijk proces dan worden gewaarborgd", zegt Vetzo, co-auteur van Algoritmes en Grondrechten, een evaluatie van de impact van nieuwe AI-technologieën op grondrechten - met name in Nederland - zoals privacy, vrijheid van meningsuiting en het recht op gelijke behandeling.

AI kan menselijke beslissingen op meer heimelijke manieren overstemmen. "We ontdekten dat algoritmen die zijn gekoppeld aan toepassingen in de thuissituatie, zoals slimme tv's en digitale assistenten, een 'chilling' effect kunnen veroorzaken, waarbij mensen hun gedrag aanpassen in de wetenschap dat ze misschien in de gaten worden gehouden. Dat is een grote zorg voor de privacy. Ook kan ons zicht op de wereld beperkt worden door algoritmes die inhoud selecteren op basis van onze online gewoonten, zoals bij algoritmes voor muziekaanbevelingen die zelfs oneerlijk kunnen uitpakken voor vrouwelijke artiesten."

En het lelijke - gecodeerde vooringenomenheid

Maar is het eerlijk om de technologie overal de schuld van te geven? "We moeten in gedachten houden dat AI-systemen geen neutrale systemen zijn", zegt filosoof Jan Broersen, die samen met computerwetenschapper Mehdi Dastani voorzitter is van de onderzoeksgroep Human-Centred Artificial Intelligence van de Universiteit Utrecht. "Achter AI zitten mensen die hun persoonlijke idealen meedragen over wat een goede uitkomst is of wat succes betekent; hun waarden, voorkeuren en vooroordelen komen terug in het AI-systeem."

Broersen illustreert: Stel dat je een programma ontwikkelt om huisdieren te identificeren. Als je het algoritme vervolgens traint met een miljoen afbeeldingen van honden - omdat je die nu eenmaal schattiger of vriendelijker vindt - en met maar een paar duizend foto's van katten, dan zal het idee van het algoritme over hoe een kat eruitziet minder volledig zijn, en zal het algoritme dus slechter zijn in het herkennen van katten. "Kunstmatige intelligentie kan dan een vertekend beeld geven, omdat het beslissingen neemt op basis van gegevens of trainingskeuzes die onze eigen menselijke vooroordelen bevatten", legt Broersen uit.

Een ander, groter probleem is wanneer datasets die machinelearning algoritmes voeden, gebaseerd zijn op historische discriminatie. "Dan bestaat het risico dat structurele ongelijkheden niet alleen worden gereproduceerd, maar zelfs worden versterkt." Denk aan een algoritme dat getraind is om kandidaten voor een baan te selecteren: als de meeste kandidaten in het verleden mannen waren, zal het algoritme dat patroon waarschijnlijk reproduceren en zal dit uiteindelijk resulteren in discriminatie van vrouwen.

Voorbeelden van gecodeerde vooringenomenheid zijn overal te vinden, waarvan sommige dichtbij huis, zoals de algoritmen die door de Nederlandse belastingdienst werden gebruikt en die leidden tot raciale profilering (algemeen bekend als de toeslagenaffaire). Broersen voegt daaraan toe: "Algoritmische vooringenomenheid brengt dan vooroordelen aan het licht die al welig tierden, bijvoorbeeld in jobwervingsprocedures, kredietwaardigheidsbeoordelingen en overheidstoepassingen. Zodra we ons hiervan bewust zijn, zijn machines juist ook weer gemakkelijker te ontdoen van hun vooroordelen dan de meeste mensen. Het is een kans voor onderzoekers van AI om het beter te doen."

We kunnen methoden bedenken die ons helpen niet-gewenste aannames in AI aan het licht te brengen.

Verklaarbare AI

Dus wat doen onderzoekers aan de Universiteit Utrecht om verantwoordelijke en inclusieve systemen te creëren waar we op kunnen vertrouwen? "Als AI-systemen in een black box opereren, hebben we geen inzicht in hoe we het systeem kunnen repareren als er een fout is opgetreden", zegt Natasha Alechina, coördinator van de subgroep Autonomous Intelligent Systems aan de Universiteit Utrecht en specialist in multi-agentsystemen. "Kijk naar autonome voertuigen. We moeten waarmaken dat het systeem veilig is om mee te rijden, maar we moeten er ook voor zorgen dat het beslissingsgedrag verklaarbaar is. Niet alleen moeten passagiers zich comfortabel voelen om er in te reizen, het systeem moet ook voor AI-bouwers toegankelijk zijn, opdat het geoptimaliseerd kan worden als er iets beschadigd raakt of er iemand gewond raakt."

Verklaarbare kunstmatige intelligentie betekent dat de redenering achter een beslissing volledig te volgen moet zijn voor de menselijke gebruikers ervan. Computerwetenschapper Floris Bex en zijn team van het Nationaal Politielab AI hebben een uitlegbaar AI-systeem ontworpen om de Nederlandse politie te helpen aangiften van misdrijven efficiënter te beoordelen. "Van de 40.000 klachten die burgers jaarlijks indienen, wordt slechts een klein percentage door de wet als strafbaar feit aangemerkt en als zodanig in behandeling genomen. Als een geautomatiseerd systeem niet uitlegt waarom een klacht is afgewezen, kan dit het vertrouwen van het publiek ondermijnen. Daarom hebben we een tool voor het melden van misdrijven ontworpen met een chatbot die een zo natuurlijk mogelijk klinkende stem gebruikt en die redeneert met juridische argumenten, zodat burgers een begrijpelijke en juridisch zinnige uitleg krijgen waarom hun aangifte niet in behandeling wordt genomen."

Voor de duidelijkheid: een verklaarbaar systeem kan nog steeds vatbaar zijn voor gecodeerde vooringenomenheid en fouten. "Eigenlijk krijgen we misschien nooit volledig onbevooroordeelde AI-modellen", geeft Dong Nguyen toe, assistent-professor Natural Language Processing aan de Universiteit Utrecht. "Wat we wel kunnen doen is methoden bedenken die ons helpen niet-gewenste aannames in AI aan het licht te brengen, zodat degenen die door een beslissing worden geraakt de uitkomst ervan kunnen aanvechten." Een methode waar Nguyen zich in het bijzonder op richt, is het publiekelijk beschikbaar maken van algoritmische modellen voor toetsing en evaluatie. Ze werkt ook aan een visualisatietool waarmee kan worden herleid wat de modellen hebben geleerd, zodat aspecten die verantwoordelijk zijn voor onverantwoordelijke keuzes gemakkelijk kunnen worden opgepikt. "Stel dat een algoritme een restaurant slecht beoordeelt. Als uit de uitleg blijkt dat deze beslissing gebaseerd is op een twijfelachtige variabele, zoals een buitenlands klinkende naam in plaats van op de service van het restaurant, dan kan de eigenaar de beslissing weerleggen."

Algoritmische verantwoordelijkheid

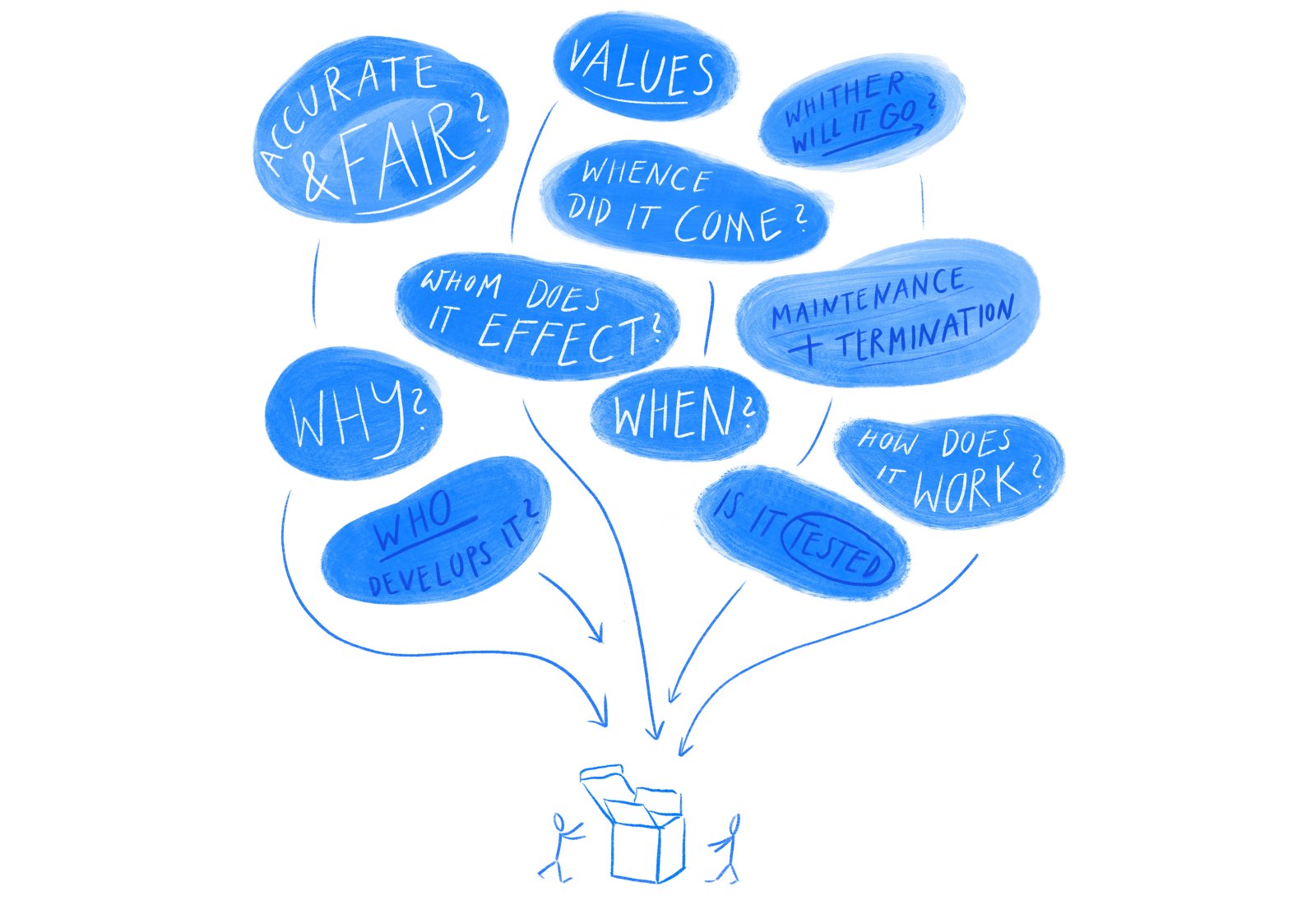

Verklaarbare AI kan ons helpen te begrijpen hoe een systeem tot een beslissing is gekomen, maar is op zichzelf niet genoeg om misstanden te voorkomen. "We moeten iedereen die betrokken is bij de ontwikkeling of inzet van algoritmes verantwoordelijk maken voor de impact die deze systemen hebben op onze wereld", zegt mediawetenschapper Maranke Wieringa, die onderzoek doet naar algoritmische verantwoordelijkheid. "Het vormgeven van de verantwoordelijkheid in AI vereist dat we kritische vragen stellen: wie ontwierp wat, waarom, in welke context, in welke periode, hoe werkt het, wie beïnvloedt het, waarheen gaat het systeem, en waar kwam het uit voort?"

Wieringa ontwikkelt nu met collega's van de Utrecht Data School en in samenwerking met Nederlandse gemeenten een tool - BIAS - die ambtenaren aanspoort om na te denken over de impact die algoritmische systemen op hun gemeenschap hebben, nog voordat deze worden geïmplementeerd; bijvoorbeeld over de implicaties van het gebruik van algoritmen om te voorspellen hoe groot de kans is dat iemand fraude pleegt met uitkeringen of een lening terugbetaalt. De gedachtestroom die dit proces met zich meebrengt, illustreert Wieringa met een reeks vragen: "Hoe borgen we non-discriminatie in ons systeem? Waarom wordt het gelegitimeerd? Wie is verantwoordelijk als het systeem niet goed werkt? Hoe hoog mag het foutpercentage zijn? Hebben we alternatieven voor AI overwogen? En zo ja, waarom zijn die verworpen?"

Wieringa put uit de ervaring van de door de Utrecht Data School ontwikkelde Data Ethics Decision Aid (DEDA), een toolkit die data-analisten, projectmanagers en beleidsmakers helpt om te herkennen welke ethische kwesties er mogelijk spelen bij dataprojecten van de overheid. "Door een besluitvormingsproces te faciliteren rond welke waarden - bijvoorbeeld efficiëntie, openheid of legitimiteit - belangrijk zijn voor de organisatie, stimuleert DEDA het waardegevoelig ontwerpen en veranderingen in de governance om verantwoord te reageren op de ethische uitdagingen die algoritmen vormen", zegt Mirko Schaefer, mede-oprichter van Utrecht Data School. "Veel gemeenten en ministeries in Nederland maken al gebruik van DEDA om data en algoritmes op een verantwoorde manier te implementeren."

Praktisch gezien, zegt Schaefer, stelt dit participatieve proces gebruikers van algoritmes in staat om hun keuzes te documenteren, zodat waarden (en vooroordelen) die in het systeem gebakken zitten nu en in de toekomst traceerbaar zijn. "Algoritmes zijn gesitueerd in een context en op een bepaalde locatie, maar onze normen en waarden veranderen. Wat we vijftig jaar geleden aanvaardbaar vonden, kan nu onaanvaardbaar zijn. Tools als BIAS en DEDA helpen organisaties om hun keuzes in de loop van de tijd te herzien en hun ontwerp daarop aan te passen." Samen met collega's van de Utrecht Data School zijn Schaefer en hoogleraar grondrechten Janneke Gerards een Impact Assessment for Human Rights and Algorithms (IAMA) gestart, gericht op het voorkomen van schendingen van de rechten van de mens, zoals bij de toeslagenaffaire.

Toekomstgerichte verantwoordelijkheid

Zelfrijdende auto's zijn een goed voorbeeld van een situatie waarbij de wet het niet kan bijbenen: alle verkeerswetten gaan ervanuit dat er een mens is die stuurt en remt. In plaats van het aan regelgeving over te laten, denken Utrechtse onderzoekers nu na over hoe we autonome systemen kunnen ontwerpen die zich in de toekomst niet meer verkeerd gedragen - ook in situaties die we nu nog niet kunnen voorzien.

Deontische logica kan ons een basis geven voor machine-ethiek.

Eén zo'n instrument is deontische logica, zegt Jan Broersen, die een project leidt om intelligente systemen voor te bereiden om zich volgens ethische en juridische principes te gedragen. "Deontische logica gaat over hoe je correct kunt redeneren met normen, ofwel met verplichtingen, toestemmingen en verboden die deel uitmaken van een morele of wettelijke code. Het zou ons kunnen informeren over wanneer het gepast is voor een zelfrijdende auto om verkeerswetten te overtreden om groter kwaad te voorkomen, bijvoorbeeld wanneer iemand met spoed naar het ziekenhuis moet worden gebracht om diens leven te redden. Als deontische logica ons modellen kan geven voor hoe we gegeven bepaalde waarnemingen als input op de juiste manier conclusies kunnen trekken over wat een AI wel of niet moet doen of niet mag doen, hebben we een basis voor machine-ethiek. En we kunnen meer vertrouwen hebben in dergelijke (deontische) op logica gebaseerde modellen dan in modellen die via machinelearning moeten leren hoe ze zich ethisch moeten gedragen."

Met het tempo van de veranderingen zijn ook innovatieve vormen van regulering nodig, voegt Pınar Yolum, universitair hoofddocent Intelligent Systems, toe. "Het kan zijn dat onze verkeerswetten moeten veranderen, omdat zelfrijdende auto's in de toekomst in staat zullen zijn om met elkaar te praten en beslissingen te nemen, bijvoorbeeld over wie voorrang heeft bij een oversteekplaats. Dit vereist dat AI-systemen iets heel menselijks gaan doen, namelijk argumentatie gebruiken om te onderhandelen en te overtuigen." Yolum onderzoekt hoe apparaten zo kunnen worden getraind dat ze namens ons beslissingen kunnen nemen, rekeninghoudend met onze privacy-voorkeuren.

Overigens nodigt deze onderzoekslijn uit tot nadenken over het proces van vertrouwen in deze systemen. "We delegeren zelf immers de hele tijd verantwoordelijkheden aan andere mensen. We bouwen het vertrouwen in hen op door ze kleine taken te geven. Ik vergelijk het wel eens met kinderen: 'Oké, je mag nu naar het park aan de overkant van de straat en dan mag je morgen naar de winkel om de hoek. Misschien kan je dan over een jaar alleen naar de binnenstad toe.’ Via deze interacties en hun resultaten bouw je vertrouwen op. Hetzelfde geldt voor autonome vertegenwoordigers. Dat is hoe ik de relatie tussen mensen en autonome systemen in de toekomst voor me zie."

Verschillende vaardigheden en mensen

Ten slotte, als we erop willen vertrouwen dat AI de goede kant op gaat, moeten we iedereen erbij betrekken: verschillende vaardigheden en teams die elkaars vooroordelen controleren om een meer inclusieve output voort te brengen. En dit begint met ons onderwijs: "We rusten een nieuwe generatie AI-professionals uit met interdisciplinaire vaardigheden en een moreel kompas voor de sociale context waarin technologieën evolueren", zegt Mehdi Dastani, programmaleider van de masteropleiding Artificial Intelligence en co-voorzitter van de Human-Centred Artificial Intelligence-groep aan de Universiteit Utrecht. En wel om één belangrijke reden: "AI die onze toekomstige intelligente (autonome) systemen aandrijft, is veel meer dan het leren van patronen die uit big data worden gehaald. Het gaat vooral om waardevolle representatiesystemen, correcte redeneerschema's, en om het modelleren van intelligentie die problemen en taken efficiënt en accuraat benadert. Dit zijn de modellen die kunnen profiteren van wetenschappelijke kennis die in de loop der tijd is opgebouwd in de verschillende wetenschappelijke disciplines, zoals psychologie, filosofie, linguïstiek en computerwetenschappen. Maar ook kunnen zij profiteren van verschillende culturele achtergronden en perspectieven."

We rusten een nieuwe generatie AI-professionals uit met interdisciplinaire vaardigheden en een moreel kompas.

Aan de Universiteit Utrecht werken we op diverse manieren aan het maken van betere AI: het ontwikkelen van verklaarbare systemen, opdat gebruikers hun beslissingen en uitkomsten kunnen begrijpen en eventueel aanvechten; het programmeren van verantwoordelijke machines, zodat als er iets fout gaat of vooringenomenheid insluipt organisaties dit kunnen herstellen; het interacteren met robots, zodat we mensgerichte machines creëren die onze normen en waarden integreren. We leiden ook de volgende generatie op om creatief om te gaan met de slimme systemen van de toekomst, terwijl we tegelijkertijd op onze hoede blijven om schadelijke vooruitgang of misbruik van de technologie te voorkomen. En we doen aan inclusieve AI, door interdisciplinaire samenwerking tot een handelsmerk van ons onderzoek en onderwijs te maken. Samen stellen we ons een betere toekomst voor - voor zowel mensen als machines.

Geschreven door Marta Jimenez. Vertaald door Felice Ghering.